Risoluzione dello schermo e formato? Cosa significano 720p, 1080p, 1440p, 4K e 8K?

In passato, la risoluzione dello schermo (chiamata anche risoluzione del display) non era un grosso problema. Windows aveva un paio di alternative preimpostate e, per ottenere una risoluzione maggiore o più colori (o entrambe le cose), si sarebbe dovuto installare un driver per la scheda video. Col passare del tempo si sono potute scegliere migliori schede video ed anche migliori monitor. Oggi abbiamo un sacco di scelte per quanto riguarda i display, la loro qualità e le risoluzioni supportate. In questo articolo sarete condotti attraverso un po’ di storia e vi si spiegheranno tutti i concetti essenziali, tra cui alcune sigle comuni come 1080p o 4K.

Tutto è iniziato con IBM e CGA

La tecnologia grafica a colori è stata sviluppata da IBM. CGA (Color Graphics Adapter) è stato la prima, seguita da EGA (Enhanced Graphics Adapter) e VGA (Video Graphics Array). A prescindere dalla capacità del monitor, potevate ancora scegliere tra una delle poche opzioni disponibili tramite i driver della scheda grafica. Per motivi nostalgici diamo un’occhiata ad un ben noto display CGA di una volta.

Con l’avvento dei video ad alta definizione e la crescente popolarità del formato 16:9 (tra poco verrà spiegato qualcosa di più riguardante il formato) la selezione di una risoluzione dello schermo non è più così semplice come una volta. Tuttavia, questo significa che ci sono anche molte più opzioni tra cui scegliere, con le quali poter soddisfare le preferenze di quasi tutti. Diamo un’occhiata alla terminologia odierna ed al suo significato.

Lo schermo è quanto per quanto?

Sono sicuro che alcuni di voi già sanno che il termine “risoluzione” non è corretto quando viene usato per riferirsi al numero di pixel su uno schermo. Non dice nulla su quanto densamente siano raggruppati i pixel. “Risoluzione” è tecnicamente il numero di pixel per unità di superficie piuttosto che il numero totale di pixel. In questa guida useremo il termine per come viene comunemente inteso piuttosto che da uso strettamente corretto dal punto di vista tecnologico.

Fin dall’inizio, la risoluzione è stata descritta (correttamente o meno) dal numero di pixel disposti orizzontalmente e verticalmente su un monitor, ad esempio 640 x 480 = 307200 pixel. Le possibilità di scelta erano determinate dalla capacità della scheda video e differivano da produttore a produttore.

Le risoluzioni integrate in Windows erano molto limitate per cui, se non si aveva il driver per la scheda video, si rimaneva bloccati con lo schermo sulla più bassa risoluzione fornita da Windows. Se avete seguito il programma di installazione di Windows oppure avete installato una nuova versione di un driver video, potreste aver visto per un attimo lo schermo a bassa risoluzione 640 x 480. Era brutto perfino sugli schermi CGA, ma questo era di defalt su Windows.

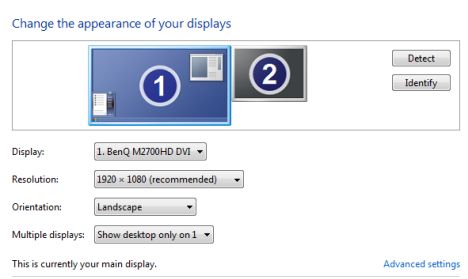

Da quando la qualità dei monitor è migliorata, Windows ha iniziato ad offrire un paio di sue alternative, ma gli oneri pesavano ancora in gran parte sui produttori di schede grafiche, soprattutto se si voleva un display ad una vera alta risoluzione. Le versioni più recenti di Windows sono in grado di rilevare la risoluzione di default dello schermo per il vostro monitor e la vostra scheda grafica e di regolarsi di conseguenza. Questo non significa che ciò che Windows sceglie sia sempre l’opzione migliore, ma funzionerà, e lo si può cambiare se lo si desidera, dopo aver visto come appare. Se avete bisogno di una guida su come si fa, date un’occhiata a questo tutorial: Cambiare la risoluzione dello schermo e rendere il testo e le icone più grandi.

Tenete a mente le P e le I

Potreste aver visto la risoluzione dello schermo descritta come qualcosa di simile a 720p o 1080i. Che cosa significa?

Per cominciare, le lettere dicono come l’immagine viene “disegnata” sul monitor. La “p” sta per progressivo e la “i” sta per interlacciato.

La scansione interlacciata è un retaggio dalla televisione e dei primi monitor CRT. Lo schermo del monitor o del televisore è dotato di linee di pixel disposti orizzontalmente che lo attraversano. Le linee erano abbastanza facili da vedere se ci si avvicinava ad un monitor o ad una TV vecchi, ma al giorno d’oggi i pixel sullo schermo sono così piccoli che sono molto difficili da vedere anche con un ingrandimento. L’elettronica del monitor “disegna” ogni schermata riga per riga, troppo velocemente per essere vista dall’occhio. Un display interlacciato disegna prima tutte le linee dispari, poi tutte le linee pari.

Dal momento che lo schermo è disegnato a linee alternate, con le scansioni interlacciate lo sfarfallio è sempre stato un problema. I produttori hanno cercato di superare questo problema in vari modi. Il metodo più comune è quello di aumentare il numero di volte che una schermata completa viene disegnata in un secondo; questo viene chiamato frequenza di aggiornamento. La frequenza di aggiornamento più comune era di 60 volte al secondo, che era accettabile per la maggior parte delle persone, ma che poteva essere leggermente aumentata per sbarazzarsi del tremolio percepito da alcune persone.

Come le persone abbandonarono i vecchi display CRT, la terminologia cambiò da frequenza di aggiornamento a frame rate, a causa della differenza nel modo in cui funziona il monitor a LED. Il frame rate è la velocità con cui il monitor visualizza ogni distinto frame di dati. Le versioni più recenti di Windows impostano il framerate a 60 Hertz, o 60 cicli al secondo, e gli schermi LED non sfarfallano. Inoltre il sistema è cambiato dalla scansione interlacciata alla scansione progressiva, perché i nuovi display digitali erano molto più veloci. In una scansione progressiva le linee sono disegnate sullo schermo in sequenza piuttosto che prima le linee dispari e poi le linee pari. Ad esempio, se si vuole interpretare “1080p”, questo viene usato per i display che sono caratterizzati da 1080 linee orizzontali di risoluzione verticale ed una scansione progressiva.

Su Wikipedia, qui, c’è un’immagine da far male agli occhi sulle differenze tra scansione progressiva e interlacciata. Per altre interessanti lezioni di storia leggete anche il video interlacciato.

E tutti quei numeri: 720p, 1080p, 1440p, 4K e 8K?

Quando le TV ad alta definizione sono diventate la norma, i produttori hanno definito delle abbreviazioni per spiegare la risoluzione dei loro display. I numeri più comuni che vedrete sono 720p, 1080p e 2160p o 4K. Come abbiamo visto, la “p” e la “i” stanno ad indicare se si tratta di un display a scansione progressiva oppure a scansione interlacciata. Queste abbreviazioni numeriche sono utilizzate a volte anche per descrivere i monitor per computer, anche se, in generale, un monitor consente di visualizzare risoluzioni più alte rispetto ad un televisore. Il numero si riferisce sempre al numero di linee orizzontali sul display.

Ecco come si traducono le abbreviazioni:

- 720p = 1280 x 720 – è generalmente noto come risoluzione HD o “HD Ready”

- 1080p = 1920 x 1080 – è generalmente noto come risoluzione FHD o “Full HD”

- 1440p = 2560 x 1440 – comunemente noto come risoluzione QHD o Quad HD ed in genere si trova su monitor per i videogame e sugli smartphone di fascia alta. 1440p è quattro volte la risoluzione del 720p HD o “HD ready”.

- 2160p = 3840 x 2160 – comunemente noto come risoluzione 4K, UHD o Ultra HD. È una risoluzione dello schermo molto grande e si trova sui televisori di fascia alta e sui monitor. 2160p è chiamato 4K perché offre quattro volte la risoluzione del 1080p FHD o “Full HD”.

- 4320p = 7680 x 4320 – è noto come 8K e offre 16 volte più pixel rispetto al normale FHD 1080p o risoluzione “Full HD”. Anche se non vedrete tanto presto televisori o monitor per pc con questa risoluzione, è possibile verificare se il vostro computer può gestire una tale quantità di dati. Ecco un esempio di video 8K: PATAGONIA 8K

Cos’è il formato?

All’inizio abbiamo menzionato il termine formato (aspect ratio). Tale termine è stato originariamente utilizzato nel cinema ed indicava quanto la larghezza dell’immagine era in relazione con la sua altezza. I film erano originariamente in formato 4:3 e questo è stato trasferito alla televisione ed ai primi display per computer. L’aspect ratio dei film è cambiato molto rapidamente in ampiezza, il che significa che quando i film sono stati mostrati in televisione hanno dovuto essere ritagliati o l’immagine è dovuta essere manipolata in altri modi per adattarsi allo schermo del televisore.

Come la tecnologia di visualizzazione è migliorata, le TV ed i monitor dei produttori hanno iniziato anch’essi ad andare verso i display widescreen. Originariamente “widescreen” si riferiva a qualcosa di più ampio del comune schermo 4:3, ma è venuto rapidamente a significare come un rapporto di 16:10 e poi 16: 9. Al giorno d’oggi, quasi tutti i monitor per computer ed i televisori sono disponibili solo in formato widescreen e le trasmissioni televisive e le pagine web si sono adattate per questioni di compatibilià.

Fino al 2010, il 16:10 è stato il formato più importante per i monitor widescreen per computer. Ma con l’aumento della popolarità della TV ad alta definizione, che stava usando risoluzioni ad alta definizione quali 720p e 1080p ed ha reso tali termini sinonimi di alta definizione, il 16: 9 è diventato l’aspect ratio standard dell’alta definizione. Oggi trovare un display 16:10 è quasi impossibile.

A seconda del formato del display si è in grado di utilizzare solo le risoluzioni che sono specifiche per la sua larghezza e la sua altezza. Alcune delle risoluzioni più comuni che possono essere utilizzate per ciascun formato sono le seguenti:

- risoluzioni del formato 4:3: 640 × 480, 800 × 600, 960 × 720, 1024 × 768, 1280 × 960, 1400 × 1050, 1440 × 1080, 1600 × 1200, 1856 × 1392, 1920 × 1440, e 2048 × 1536.

- risoluzioni del formato 16:10: 1280 × 800, 1440 × 900, 1680 × 1050, 1920 × 1200, 2560 × 1600.

- risoluzioni del formato 16:9: 1024 × 576, 1152 × 648, 1280 × 720, 1366 × 768, 1600 × 900, 1920 × 1080, 2560 × 1440 e 3840 × 2160.

In che modo la dimensione dello schermo influisce sulla risoluzione?

Anche se uno schermo di un televisore 4:3 può essere regolato per mostrare le strisce nere in alto ed in basso dello schermo mentre vi è la riproduzione di un filmato o di uno spettacolo in formato widescreen, ciò non ha senso per un monitor, difatti vi accorgerete che Windows non offre il display widescreen tra le scelte. È possibile guardare i film con le strisce nere come se si stesse guardando uno schermo televisivo, questo però viene fatto dal programma di riproduzione del film.

La cosa più importante non è la dimensione del monitor ma la sua capacità di visualizzare le immagini ad alta risoluzione. Maggiore è la risoluzione più piccole saranno le immagini sullo schermo e ad un certo punto il testo sullo schermo diverrà così piccolo che non sarà leggibile. Su un monitor più grande è possibile spingersi ad una risoluzione davvero molto elevata ma se la densità di pixel del monitor non è all’altezza, non sarà possibile avere la risoluzione massima possibile prima che l’immagine diventi illeggibile. In molti casi, se dite a Windows di usare una risoluzione del monitor che non è in grado di gestire, il monitor non visualizzerà proprio nulla. In altre parole, non aspettatevi miracoli su un monitor a basso costo. Quando si tratta di schermi ad alta definizione, otterrete di certo quello che avrete pagato.

Conclusioni

Se non siete appassionati di tecnica, è molto probabile che siate confusi da tanti tecnicismi. Speriamo che questo articolo sia riuscito ad aiutarvi nella comprensione delle caratteristiche più importanti di un display: formato, risoluzione e tipologia.

Autore: Codrut Neagu

Traduzione dell’articolo http://www.digitalcitizen.life/what-screen-resolution-or-aspect-ratio-what-do-720p-1080i-1080p-mean Copyright DigitalCitizen